Mantenha-se atualizado sobre os últimos acontecimentos em marketing digital

Você quer dados de marketing. Você quer isso rápido. Então você recebe uma pequena ajuda de seus amigos de silício. Mas está certo? A IA lhe dirá que você tem 5 milhões de instalações em Vênus? O seu relatório LLM favorito-3.000 conversões no seu jogo de Match-3 com melhor desempenho? Em outras palavras, o uso de IA resultará em dados ruins graças a uma alucinação?

As alucinações são um fato da vida com os modernos sistemas de AI baseados em LLM.

É inteligente estar preocupado com eles.

Isso é algo que tomamos muito cuidado para evitar com nossa nova integração do MCP com o Claude do Anthrópico .

- Você não quer ser aquele advogado que usou o ChatGPT para redigir um resumo que referenciou jurisprudência inexistente

- Você não vai querer ser aquela companhia aérea cujo chatbot inventou uma política de reembolso compassivo que não existia

- Você não vai querer ser aquela empresa imobiliária que anunciava vistas do Ocean no Kansas, graças a um LLM que confundiu 2 nomes de cidades de aparência semelhante

(Sim, todas as histórias verdadeiras, a propósito. Eu sei porque o Chatgpt me contou sobre elas.)

Você quer ser o herói de marketing que obtém as informações corretas e toma a decisão certa e oferece um crescimento mensurável. Mas você precisa desses dados. Você precisa rápido. E algumas paradas sexy também não machucariam.

Mas precisa estar correto. Preciso. Verdadeiro. Acionável.

Além disso, não é algo que você será demitido.

Zero Hallucination Gerated Marketing Insight

Então, como evitamos alucinações com nosso insight de marketing gerado pela IA?

Provavelmente não há solução completamente perfeita, 1000% segura aqui, mas estamos vendo resultados surpreendentes com precisão realmente sofisticada com uma abordagem de 7 etapas de várias etapas:

- Comemos o elefante 1 mordida de cada vez,

dividimos todas as perguntas do usuário em tarefas minúsculas e totalmente testadas. Cada tarefa lida com apenas uma peça ... datas, métricas, dimensões, filtros, quebras, você escolhe e depois corre em paralelo. Quebrar tarefas dessa maneira permite que o modelo se concentre em uma coisa de cada vez, permite validar cada etapa e reduzir o tempo de resposta e, ao mesmo tempo, aumentar a precisão. - Esquemas rigorosos,

aplicamos esquemas rígidos para todas as tarefas. Se uma data de início ocorrer após uma data de término ou um nome métrico for desconhecido, o fluxo para imediatamente e retorna um erro claro em vez de inventar dados. - Nenhuma adivinhação permitida

como uma pessoa competente altamente segura, permitimos que o modelo admitisse incerteza. Quando falta as informações necessárias, o LLM pode responder "Não tenho informações suficientes", impedindo suposições criativas. - Beijo: Mantenha simples, estúpido,

mantemos todos os prontos magros. Nós ignoramos as tarefas que sua resposta desejada não precisa, como filtrar quando o usuário não solicitou. Isso reduz o ruído, a latência e o uso do token. - Pequeno é lindo,

projetamos cada modelo para fazer apenas 1 trabalho pequeno: nada mais. As chamadas claras e de fins únicas impedem a injeção imediata, mantendo as saídas previsíveis. - Observabilidade, registro, avaliação diária

que enviamos com plena observabilidade e loops diários de avaliação. Cada execução é registrada e reproduzível, e uma mistura de testes de unidade, testes de integração e um LLM-AS-A-JUDGE automatizado verifica o modelo em relação às métricas das chaves, para que a qualidade melhore com o tempo. - Falhas amigáveis,

lidamos com o fracasso graciosamente. Se algo der errado, os usuários veem uma sugestão de língua simples, como "Experimente um intervalo mais curto" em vez de algum rastreamento de pilha enigmática.

Adicione tudo e você obtém painéis confiáveis que correspondem ao que você veria se puxasse todos os dados da maneira antiquada no Singular manualmente.

Ele também acelera suas respostas, porque pequenas tarefas executadas em paralelo por meio de avisos menores oferecem respostas em segundos.

Bônus extras:

- A prova de futuro

mais LLMs está oferecendo recursos de integração MCP. Com todas essas etapas, os guardrails permanecem como parceiros adicionais a bordo. - Paz de espírito

Os advogados que argumentaram seu caso em precedentes inexistentes foram sancionados e multados. Com todas essas verificações e saldos, você pode ter certeza de que os dados que está recebendo do seu ajudante de IA são seguros, validados e mantêm surpresas no mínimo.

Resumir tudo, e nossa integração do MCP, além de nossas melhores práticas de integridade de dados, ajudam -nos a fornecer dados precisos e fundamentados que são validados continuamente.

Isso significa que suas perguntas simples em inglês se transformam em insights de desempenho confiáveis. Sem alucinações, apenas números com quem você pode contar.

O uso está fora dos gráficos

Agora é um bom momento para mencionar, a propósito, que não tínhamos idéia de quantos de vocês estavam apenas esperando por esse tipo de solução.

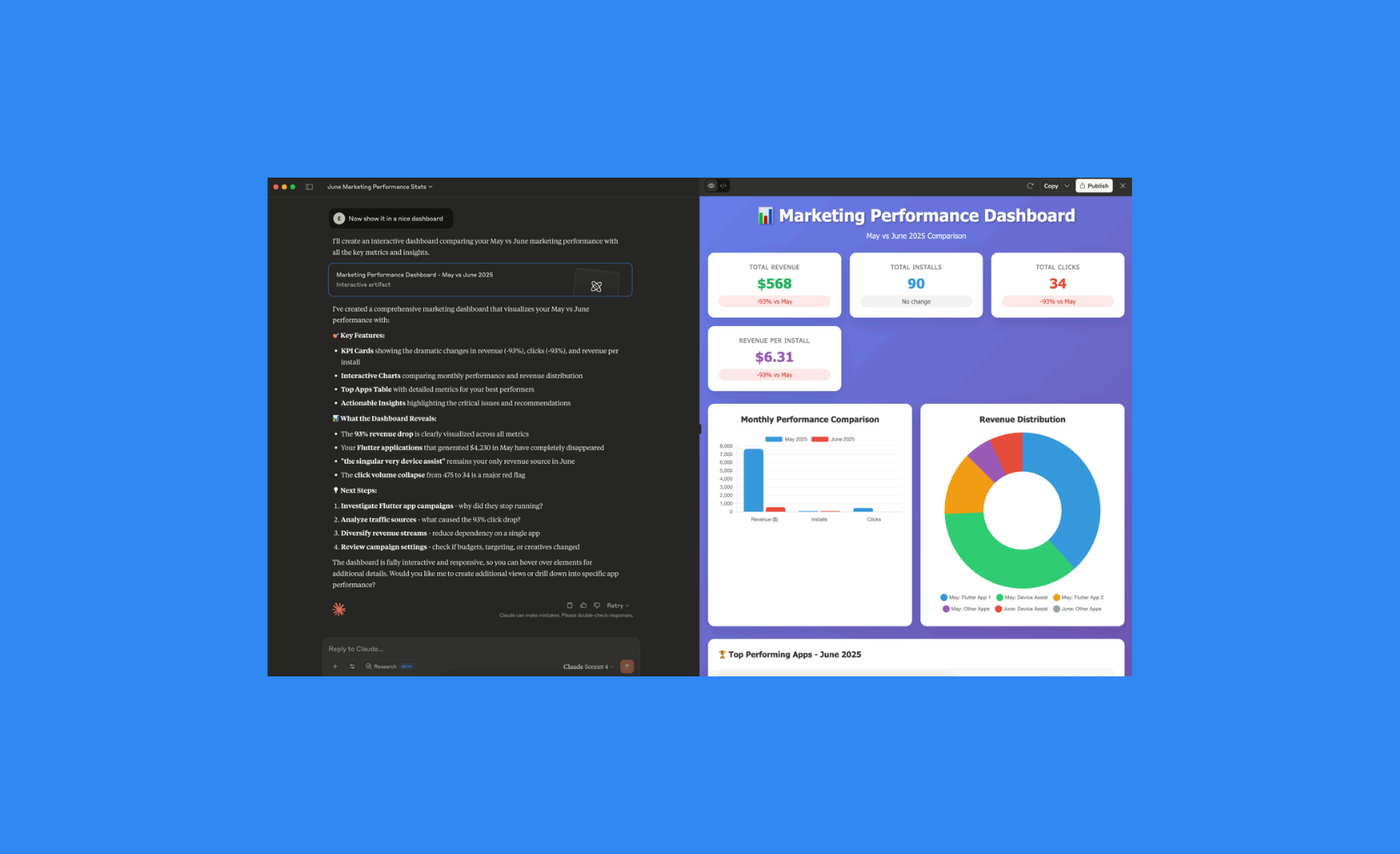

O uso está completamente fora dos gráficos. Aqui está o que parece em uma conta de demonstração:

Há literalmente um CTO de uma grande empresa de jogos mobile que está usando isso diariamente. (Quero dizer, esperávamos que as pessoas não técnicas saltassem isso rapidamente, mas acontece que os nerds entre nós também gostam de dados rápidos e fáceis.) Os gráficos que Claude está quase instantaneamente criando para ele também são muito legais: instalações totais, custo total, receita total, LTV, ROI, média dau, arpu, arpdau… seu nome.

E não são apenas os dados.

Graças à magia dos LLMs Super-Smart de hoje, as pessoas estão recebendo informações, não alucinações:

- Mudança recente: menor volume, mas de maior qualidade

- Novo: Melhoria maciça na lucratividade

- Maior custo UA no último mês

- Melhor monetização no último mês

Se você ainda não experimentou, confira.

Qualquer dúvida, fale com seu Singular . E, se você ainda não está usando o melhor MMP do mundo como classificado pelos profissionais de marketing, não há tempo como o presente.

Ficaríamos felizes em conversar.